Lakehouse – analytiikan loogiset kerrokset ja tietomallintaminen

Lakehouse – analytiikan data-alustan arkkitehtuurista ja tietomallinnuksesta

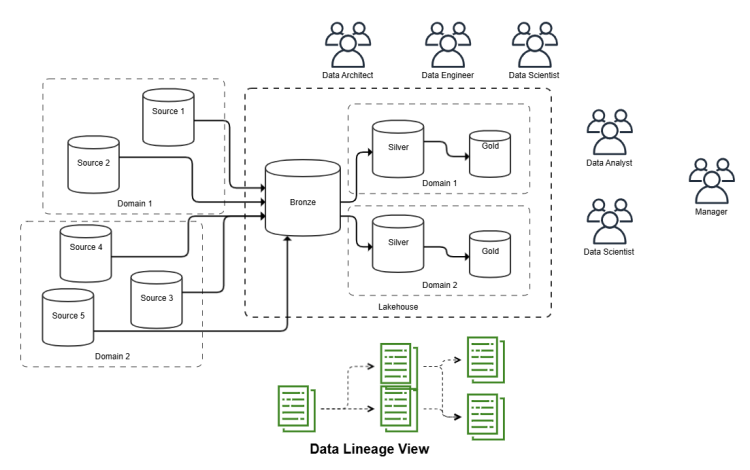

Azuressa oleva lakehouse -analytiikan data-alusta yhdistää perinteisten analyyttisten tietokantatuotteiden ja data-altaan edut tarjoten skaalautuvan ja joustavan ratkaisun suurten tietomäärien hallintaan ja analysointiin. Lakehouse – analytiikan alustalla on hyvä erotella toisistaan sen monikerrosarkkitehtuuri ja toisaalta erilaiset tavat toteuttaa fyysisiä tietomalleja näiden loogisten kerrosten kattamille objekteille, pääasiassa delta – parquet formaatissa oleville tauluille. Luonnollisesti käytettävissä on tarkoituksenmukaisesti myös muitakin tiedostoformaatteja, mutta Azuressa tämä on tyypillisin koska sekä Microsoft että Databricks ovat sitoutuneet näiden käyttöön.

Lakehouse – analytiikan loogiset kerrokset

Azureen toteutetussa lakehouse – analytiikan alustalla on useita loogisia kerroksia, joista jokaisella on oma roolinsa tiedon hallinnassa ja analysoinnissa. On mahdollista että lakehouse – analytiikan alustan data on pilkottu vielä useisiin loogisiin osiin kohdealueen / domainin mukaan jolloin näitä loogisia kerroksia onkin useampia. Ja jokaiselle kohdealueelle / domainille löytyy vielä erikseen ympäristöt kehitykselle, testaukselle sekä tuotannolle. Näitä arkkitehtuurin mukaisia kerroksia ovat alla luetellut kerrokset.

Raakatietokerros

Raakatietokerros on lähtökohta kaikelle tiedonhallinnalle lakehouse-analytiikan alustan arkkitehtuurissa. Tähän kerrokseen tallennetaan kaikki alkuperäinen ja käsittelemätön data sellaisena kuin se on vastaanotettu eri lähteistä mutta tallennettuna delta-parquet formaatissa. Lähdetieto on usein semi-strukturoitua tai strukturoimatonta, ja se voi sisältää lokitiedostoja, tapahtumatietoja tai IoT-datavirtoja. Ennen raakatietokerrosta voi olla myös olemassa erilliset Files / Volumes – loogiset hakemistosijainnit raakadatalle alkuperäisessä muodossaan mutta jotka viittaavat sellaiseen sijaintiin joka on käytettävissä alustan dataintegraatiotyökaluin. Englanniksi tämä kerros on nimeltään Bronze layer.

Puhdistus- ja muunnoskerros

Puhdistus- ja muunnoskerros vastaa raakadatan jalostamisesta ja sen muuntamisesta analysoitavaan muotoon. Tämä sisältää tietojen puhdistamisen, transformoinnin, rikastamisen ja yhdistämisen muista lähteistä saatuihin tietoihin niin että lopputuloksena muodostuu yhtenmukaista tietoa jostain osa-alueesta kunkin objektin osalta. Tavoitteena on tuottaa laadukasta dataa, joka on valmis analysoitavaksi tai jatkokäyttöön. Englanniksi tämä kerros on nimeltään Silver layer.

Esityskerros datalle

Esityskerroksen roolina on vastata jalostetun datan aggregoinnista ja sen valmistelusta analytiikkaa ja raportointia varten. Tässä kerroksessa data muokataan sellaisiin fyysisiin tietomalleihin, jotka tukevat datan nopeaa ja tehokasta kyselyä ja raportointia. Englanniksi tämä kerros on nimeltään Gold layer.

Tietomallinnus ja fyysinen tietomalli

Organisaation informaatioarkkitehtuuri määrittää sen tietomallinnuksen käytännöt, kuitenkin tyypillisesti fyysinen tietomalli määrittelee, miten data tallennetaan, jäsennetään ja hallinnoidaan Azuren lakehouse – analytiikan alustalla.

Looginen kerrosarkkitehtuuri ei suoraan määritä millaisia tietomalleja on käytössä, tähän liittyen on tehtävä valintoja. Toiminnalliset vaatimukset ja teknologia yhdessä ovat tässä valinnassa keskeisessä roolissa.

Tiedostoformaattina parquet ja päällä delta - hallintakerros

Azuren lakehouse -analytiikan alustalla data tallennetaan tyypillisesti käyttäen analytiikan käyttötarkoituksiin optimoitua parquet – tiedostoformaattia, jonka päällä on vielä erikseen delta – hallintakerros, näiden avulla parquet – muodossa tallennettu data voidaan esittää perinteisten tietokantatuotteiden taulua vastaavassa muodossa.

- Parquet on tehokas datan tallennusratkaisu

- Parquet on yhteentoimiva

- Parquet on avoimen lähdekoodin toteutus, ohjelmistovalmistajasta riippumaton

- Parquet mahdollistaa halutun osajoukon nopean haun tiedostosta

Delta - hallintakerroksen pääasiallinen hyöty parquet - tiedostoformaatin päällä on sen kyky hallita ja seurata tiedon muutoksia. Delta mahdollistaa versionhallinnan, eli muutosten jäljittämisen ja palauttamisen aikaisempiin tiloihin. Tämä tekee datan hallinnasta turvallisempaa ja luotettavampaa suhteessa puhtaan tiedontallennukseen optimoidun tiedostoformaatin käyttöön, koska virhetilanteissa tiedot voidaan palauttaa aikaisempaan tilaan.

Keskeinen deltan tarjoama hyöty on myös tehokkuus. Delta - hallintakerros parantaa suorituskykyä tallentamalla ja muokkaamalla vain muuttuneet tiedon osat, mikä vähentää tarpeetonta tietojen kopiointia ja parantaa tallennustilan käyttöä. Näin myös kyselyjen suorituskyky paranee, koska kyselyt voivat hyödyntää vain muuttuneita tietoja, mikä nopeuttaa analysointiprosessia.

Lisäksi Delta - hallintakerros tukee ACID - ominaisuuksia (Atomicity, Consistency, Isolation, Durability), jotka varmistavat tiedon eheyden ja yhtenäisyyden. Tämä tekee siitä luotettavamman ratkaisun tietojen tallennukseen ja käsittelyyn erityisesti monimutkaisten ja kriittisten sovellusten kohdalla.

Deltataulut

Taulut muodostavat useimmiten fyysisen tietomallin perustan. Ne määrittelevät, miten data järjestetään ja jäsennetään. Taulukin on looginen määritelmä datalle jonka tallennusratkaisuna on kokoelma parquet – tiedostoja ja päällä delta – hallintakerros.

Ei ole ollenkaan selvää millainen tietomallinnuksen metodologia valitaan käytettäväksi eri loogisiin kerroksiin, yleisesti ottaen tietynlaisen suoraviivaisuuden nimissä olisi hyödyllistä käyttää Ralf Kimballin popularisoimaa dimensiomallia niissä kerroksissa joissa tavoite on tuottaa yhdenmukaista tietoa. Tällöin sen loogisen kerroksen delta – taulut koostuvat seuraavanlaisista objekteista:

- Dimensiotaulut sisältävät tiedot eri dimensioista, kuten ajasta, paikasta ja tuotteista, jotka auttavat tietojen kontekstualisoinnissa.

- Faktataulut sisältävät mittareita ja tapahtumatietoa ja ovat analyysin ja raportoinnin perusta.

Vaihtoehtoinen ja tietyissä tapauksissa toimiva metodologia voisi olla myös jonkinlainen toimialan tietomallin implementaation kolmannen normaalimuodon muoto jokaiselle sen tietomallin kattamalle objektille.

Yhteenveto

Azuren palveluita käyttävä lakehouse -analytiikan data-alusta tarjoaa tehokkaan ja joustavan ratkaisun suurten tietomäärien hallintaan ja analysointiin. Loogiset kerrokset, kuten raakatietokerros, puhdistus- ja muunnoskerros sekä esityskerros, muodostavat tiedonhallinnan perustan. Tiedontallennusratkaisut sekä fyysinen tietomalli toteuttavat käytännössä organisaation informaatioarkkitehtuuria ja toiminnallisia vaatimuksia analytiikalle. Yhdessä nämä kaikki mahdollistavat monipuolisen ja skaalautuvan analytiikkaratkaisun, joka vastaa erilaisiin liiketoimintatarpeisiin.

Ready Solutionin asiantuntijoiden kokemuksen mukaan nykyään on toimivimmat teknologiat Microsoftin Azuren pilvipalvelussa perustuvat Fabricin sekä toisaalta Azure Databricksin käyttöön.